Окончание. Начало в №2, №3 2016

6. Энтропия Шеннона

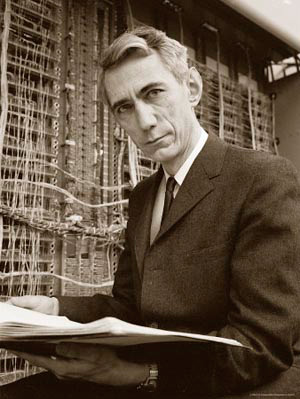

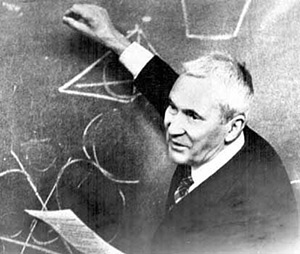

американский инженер и математик,

основатель теории информации,

т.е. теории обработки, передачи

и хранения информации

Клод Шеннон первым начал интерпретировать передаваемые сообщения и шумы в каналах связи с точки зрения статистики, рассматривая как конечные, так и непрерывные множества сообщений. Клода Шеннона называют «отцом теории информации».

Одной из самых известных научных работ Клода Шеннона является его статья «Математическая теория связи», опубликованная в 1948 году.

В этой работе Шеннон, исследуя проблему рациональной передачи информации через зашумленный коммуникационный канал, предложил вероятностный подход к пониманию коммуникаций, создал первую, истинно математическую, теорию энтропии как меры случайности и ввёл меру дискретного распределения p вероятности на множестве альтернативных состояний передатчика и приёмника сообщений.

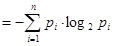

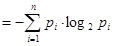

Шеннон задал требования к измерению энтропии и вывел формулу, ставшую основой количественной теории информации:

H (p) .

.

Здесь n – число символов, из которых может быть составлено сообщение (алфавит), H – информационная двоичная энтропия.

На практике значения вероятностей pi в приведённой формуле заменяют их статистическими оценками: pi  – относительная частота i-го символа в сообщении, где N – число всех символов в сообщении, Ni – абсолютная частота i-го символа в сообщении, т.е. число встречаемости i-го символа в сообщении.

– относительная частота i-го символа в сообщении, где N – число всех символов в сообщении, Ni – абсолютная частота i-го символа в сообщении, т.е. число встречаемости i-го символа в сообщении.

Во введении к своей статье «Математическая теория связи» Шеннон отмечает, что в этой статье он расширяет теорию связи, основные положения которой содержатся в важных работах Найквиста и Хартли.

американский инженер шведского

происхождения, один из пионеров

теории информации

Первые результаты Найквиста по определению ширины частотного диапазона, требуемого для передачи информации, заложили основы для последующих успехов Клода Шеннона в разработке теории информации.

В 1928 году Хартли ввёл логарифмическую меру информации H = K · log2 N, которую часто называют хартлиевским количеством информации.

Хартли принадлежит следующая важная теорема о необходимом количестве информации: если в заданном множестве M, состоящем из N элементов, содержится элемент x, о котором известно только то, что он принадлежит этому множеству M, то, чтобы найти x, необходимо получить об этом множестве количество информации, равное log2 N бит.

Кстати, отметим, что название БИТ произошло от английской аббревиатуры BIT – BInary digiT. Этот термин впервые был предложен американским математиком Джоном Тьюки в 1946 году. Хартли и Шеннон использовали бит как единицу измерения информации.

Вообще, энтропия Шеннона – это энтропия множества вероятностей p1, p2,…, pn.

– американский учёный-электронщик

Строго говоря, если X – конечная дискретная случайная величина, а p1, p2,…, pn – вероятности всех её возможных значений, то функция H (X ) задаёт энтропию этой случайной величины, при этом, хотя X и не является аргументом энтропии, можно записывать H (X )

задаёт энтропию этой случайной величины, при этом, хотя X и не является аргументом энтропии, можно записывать H (X ) .

.

Аналогично, если Y – конечная дискретная случайная величина, а q1, q2,…, qm – вероятности всех её возможных значений, то для этой случайной величины можно записывать H (Y ) .

.

американский математик. Тьюки избрал

бит для обозначения одного разряда

в двоичной системе счисления

Шеннон назвал функцию H(X ) энтропией по совету Джона фон Неймана.

энтропией по совету Джона фон Неймана.

Нейман убеждал: эту функцию следует назвать энтропией «по двум причинам. В первую очередь, Ваша функция неопределённости была использована в статистической механике под этим именем, так что у неё уже есть имя. На втором месте, и что более важно, никто не знает, что такое энтропия на самом деле, так что в дискуссии Вы всегда будете иметь преимущество».

Надо полагать, что этот совет Неймана не был простой шуткой. Скорее всего, и Джон фон Нейман и Клод Шеннон знали об информационной интерпретации энтропии Больцмана как о величине, характеризующей неполноту информации о системе.

В определении Шеннона энтропия – это количество информации, приходящейся на одно элементарное сообщение источника, вырабатывающего статистически независимые сообщения.

7. Энтропия Колмогорова

Колмогоров (1903-1987) –

советский учёный, один из крупнейших

математиков XX века

А.Н. Колмогоровым были получены фундаментальные результаты во многих областях математики, в том числе в теории сложности алгоритмов и теории информации.

В частности, ему принадлежит ключевая роль в превращении теории информации, сформулированной Клодом Шенноном как технической дисциплины, в строгую математическую науку, и в построении теории информации на принципиально иной, отличной от шенноновской, основе.

В своих работах по теории информации и в области теории динамических систем А.Н. Колмогоров обобщил понятие энтропии на эргодические случайные процессы через предельное распределение вероятностей. Чтобы понять смысл этого обобщения, необходимо знать основные определения и понятия теории случайных процессов.

Значение энтропии Колмогорова (еще называемой K-энтропией) задает оценку скорости потери информации и может интерпретироваться как мера «памяти» системы, или мера скорости «забывания» начальных условий. Её можно также рассматривать как меру хаотичности системы.

8. Энтропия Реньи

венгерский математик, создатель

Математического института в Будапеште,

ныне носящего его имя

Альфред Реньи ввёл однопараметрический спектр энтропий Реньи.

С одной стороны, энтропия Реньи представляет собой обобщение энтропии Шеннона. А с другой стороны, одновременно с этим она представляет собой обобщение расстояния (расхождения) Кульбака-Лейблера. Отметим также, что именно Реньи принадлежит полное доказательство теоремы Хартли о необходимом количестве информации.

Расстояние Кульбака-Лейблера (информационная дивергенция, относительная энтропия) – это несимметричная мера удалённости друг от друга двух вероятностных распределений.

Обычно одно из сравниваемых распределений является «истинным» распределением, а второе распределение – предполагаемым (проверяемым) распределением, являющимся приближением первого.

Пусть X, Y – это конечные дискретные случайные величины, для которых области возможных значений принадлежат заданному множеству и известны функции вероятности: P (X = ai) = pi и P (Y = ai) = qi.

Тогда значение DKL расстояния Кульбака-Лейблера вычисляется по формулам

DKL (X, Y ) = , DKL (Y, X ) =

, DKL (Y, X ) = .

.

В случае абсолютно непрерывных случайных величин X, Y, заданных своими плотностями распределения, в формулах для вычисления значения расстояния Кульбака-Лейблера суммы заменяются соответствующими интегралами.

Расстояние Кульбака-Лейблера всегда является неотрицательным числом, при этом оно равно нулю DKL(X, Y) = 0 тогда и только тогда, когда для заданных случайных величин почти всюду справедливо равенство X = Y.

В 1960 году Альфред Реньи предлагает своё обобщение энтропии.

Энтропия Реньи представляет собой семейство функционалов для количественного разнообразия случайности системы. Реньи определил свою энтропию как момент порядка α меры ε-разбиения (покрытия).

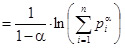

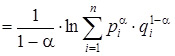

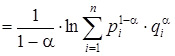

Пусть α – заданное действительное число, удовлетворяющее требованиям α ≥ 0, α ≠ 1. Тогда энтропия Реньи порядка α определяется формулой Hα = Hα (X ) , где pi = P (X = xi) – вероятность события, состоящего в том, что дискретная случайная величина X окажется равна своему соответствующему возможному значению, n – общее число различных возможных значений случайной величины X.

, где pi = P (X = xi) – вероятность события, состоящего в том, что дискретная случайная величина X окажется равна своему соответствующему возможному значению, n – общее число различных возможных значений случайной величины X.

Для равномерного распределения, когда p1 = p2 =…= pn =1/n, все энтропии Реньи равны Hα (X ) = ln n.

В противном случае, значения энтропий Реньи слабо уменьшаются при возрастании значений параметра α. Энтропии Реньи играют важную роль в экологии и статистике как индексы разнообразия.

Энтропия Реньи также важна в квантовой информации, она может быть использована в качестве меры сложности.

Рассмотрим некоторые частные случаи энтропии Реньи для конкретных значений порядка α:

1. Энтропия Хартли: H0 = H0 (X ) = ln n, где n – мощность области возможных значений конечной случайной величины X, т.е. количество различных элементов, принадлежащих множеству возможных значений;

2. Информационная энтропия Шеннона: H1 = H1 (X ) = H1 (p) (определяется как предел при α → 1, который несложно найти, например, с помощью правила Лопиталя);

(определяется как предел при α → 1, который несложно найти, например, с помощью правила Лопиталя);

3. Корреляционная энтропия или столкновение энтропии: H2 = H2 (X ) = – ln ( X = Y );

= – ln ( X = Y );

4. Min-энтропия: H∞ = H∞(X ) .

.

Отметим, что для любого неотрицательного значения порядка (α ≥ 0) всегда выполняются неравенства H∞(X ) ≤ Hα (X ). Кроме того, H2 (X ) ≤ H1 (X ) и H∞(X ) ≤ H2 (X ) ≤ 2·H∞(X ).

Альфред Реньи ввёл не только свои абсолютные энтропии (1.15), он определил также спектр мер расхождений, обобщающих расхождения Кульбака-Лейбнера.

Пусть α – заданное действительное число, удовлетворяющее требованиям α > 0, α ≠ 1. Тогда в обозначениях, использованных при определении значения DKL расстояния Кульбака-Лейблера, значение расхождения Реньи порядка α определяется формулами

Dα(X, Y ) , Dα(X, Y )

, Dα(X, Y ) .

.

Расхождение Реньи также называют alpha-расхождением или α-дивергенцией. Сам Реньи использовал логарифм по основанию 2, но, как всегда, значение основания логарифма абсолютно неважно.

9. Энтропия Тсаллиса

бразильский физик

греческого происхождения

В 1988 году Константино Тсаллис предложил новое обобщение энтропии, являющееся удобным для применения с целью разработки теории нелинейной термодинамики.

Предложенное им обобщение энтропии, возможно, в ближайшем будущем сможет сыграть существенную роль в теоретической физике и астрофизике.

Энтропия Тсаллиса Sq, часто называемая неэкстенсивной (неаддитивной) энтропией, определяется для n микросостояний согласно следующей формуле:

Sq = Sq (X ) = Sq (p) = K· ,

,  .

.

Здесь K – размерная константа, если размерность играет важную роль для понимания задачи.

Тсаллис и его сторонники предлагают развивать «неэкстенсивную статистическую механику и термодинамику» в качестве обобщения этих классических дисциплин на случай систем с длинной памятью и/или дальнодействующими силами.

От всех других разновидностей энтропии, в т.ч. и от энтропии Реньи, энтропия Тсаллиса отличается тем, что не является аддитивной. Это принципиальное и важное отличие.

Тсаллис и его сторонники считают, что эта особенность даёт возможность построить новую термодинамику и новую статистическую теорию, которые способы просто и корректно описывать системы с длинной памятью и системы, в которых каждый элемент взаимодействует не только с ближайшими соседями, но и со всей системой в целом или её крупными частями.

Примером таких систем, а поэтому и возможным объектом исследований с помощью новой теории, являются космические гравитирующих системы: звёздные скопления, туманности, галактики, скопления галактик и т.п.

Начиная с 1988 года, когда Константино Тсаллис предложил свою энтропию, появилось значительное число приложений термодинамики аномальных систем (с длиной памятью и/или с дальнодействующими силами), в том числе и в области термодинамики гравитирующих систем.

10. Квантовая энтропия фон Неймана

американский математик и физик

венгерского происхождения

Энтропия фон Неймана играет важную роль в квантовой физике и в астрофизических исследованиях.

Джон фон Нейман внёс значительный вклад в развитие таких отраслей науки, как квантовая физика, квантовая логика, функциональный анализ, теория множеств, информатика и экономика.

Он являлся участником Манхэттенского проекта по разработке ядерного оружия, одним из создателей математической теории игр и концепции клеточных автоматов, а также основоположником современной архитектуры компьютеров.

Энтропия фон Неймана, как всякая энтропия, связана с информацией: в данном случае – с информацией о квантовой системе. И в этом плане она играет роль фундаментального параметра, количественно характеризующего состояние и направление эволюции квантовой системы.

В настоящее время энтропия фон Неймана широко используется в различных формах (условная энтропия, относительная энтропия и т.д.) в рамках квантовой теории информации.

Различные меры запутанности непосредственно связаны с энтропией фон Неймана. Тем не менее, в последнее время появился ряд работ, посвящённых критике энтропии Шеннона как меры информации и возможной её неадекватности, и, следовательно, неадекватности энтропии фон Неймана как обобщения энтропии Шеннона.

Проведенный обзор (к сожалению, беглый, а порой и недостаточно математически строгий) эволюции научных взглядов на понятие энтропии позволяет дать ответы на важные вопросы, связанные с истинной сущностью энтропии и перспективами применения энтропийного подхода в научных и практических исследованиях. Ограничимся рассмотрением ответов на два таких вопроса.

Первый вопрос: имеют ли между собой многочисленные разновидности энтропии, как рассмотренные, так и не рассмотренные выше, что-нибудь общее кроме одинакового названия?

Этот вопрос возникает естественным образом, если принять во внимание то разнообразие, которое характеризует существующие различные представления об энтропии.

На сегодня научное сообщество не выработало единого, признанного всеми, ответа на этот вопрос: одни учёные отвечают на этот вопрос утвердительно, другие – отрицательно, третьи – относятся к общности энтропий различных видов с заметной долей сомнения...

Клаузиус, по-видимому, был первым учёным, убеждённым в универсальном характере энтропии и полагавшим, что во всех процессах, происходящих во Вселенной, она играет важную роль, в частности, определяя их направление развития во времени.

Кстати, именно Рудольфу Клаузиусу принадлежит одна из формулировок второго начала термодинамики: «Невозможен процесс, единственным результатом которого являлась бы передача тепла от более холодного тела к более горячему».

Эту формулировку второго начала термодинамики называют постулатом Клаузиуса, а необратимый процесс, о котором идёт речь в этом постулате, – процессом Клаузиуса.

Со времени открытия второго начала термодинамики необратимые процессы играли уникальную роль в физической картине мира. Так, знаменитая статья 1849 года Уильяма Томпсона, в которой приведена одна из первых формулировок второго начала термодинамики, называлась «Об универсальной тенденции в природе к диссипации механической энергии».

Отметим также, что и Клаузиус был вынужден использовать космологический язык: «Энтропия Вселенной стремится к максимуму».

бельгийско-американский физик и

химик российского происхождения,

лауреат Нобелевской премии

по химии 1977 года

К аналогичным выводам пришёл Илья Пригожин. Пригожин полагает, что принцип энтропии ответственен за необратимость времени во Вселенной и, возможно, играет важную роль в понимании смысла времени как физического феномена.

К настоящему времени выполнено множество исследований и обобщений энтропии, в том числе и с точки зрения строгой математической теории. Однако заметная активность математиков в этой области пока не востребована в приложениях, за исключением, пожалуй, работ Колмогорова, Реньи и Тсаллиса.

Несомненно, энтропия – это всегда мера (степень) хаоса, беспорядка. Именно разнообразие проявления феномена хаотичности и беспорядка обусловливает неизбежность разнообразия модификаций энтропии.

Второй вопрос: можно ли признать сферу применения энтропийного подхода обширной или все приложения энтропии и второго начала термодинамики ограничиваются самой термодинамикой и смежными направлениями физической науки?

История научного изучения энтропии свидетельствует, что энтропия – это научное явление, открытое в термодинамике, а затем успешно перекочевавшее в другие науки и, прежде всего, в теорию информации.

Несомненно, энтропия играет важную роль практически во всех областях современного естествознания: в теплофизике, в статистической физике, в физической и химической кинетике, в биофизике, астрофизике, космологии и теории информации.

Говоря о прикладной математике, нельзя не упомянуть приложения принципа максимума энтропии.

Как уже отмечалось, важными областями применения энтропии являются квантово-механические и релятивистские объекты. В квантовой физике и астрофизике такие применения энтропии представляют собой большой интерес.

Упомянем лишь один оригинальный результат термодинамики чёрных дыр: энтропия чёрной дыры равна четверти площади её поверхности (площади горизонта событий).

В космологии считается, что энтропия Вселенной равна числу квантов реликтового излучения, приходящихся на один нуклон.

Таким образом, сфера применения энтропийного подхода весьма обширна и включает в себя самые разнообразные отрасли знания, начиная с термодинамики, других направлений физической науки, информатики и заканчивая, например, историей и экономикой.

А.В. Сигал, доктор экономических наук, Крымский университет имени В.И. Вернадского

Основатель и издатель

Основатель и издатель Copyright © 2016–2021 Научно-популярный

Copyright © 2016–2021 Научно-популярный