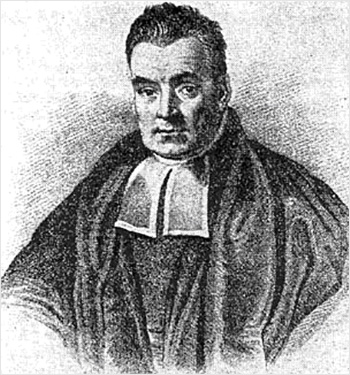

О жизни Томаса Байеса известно немного. Он родился в Лондоне в 1702 году в семье пресвитерианского священника. С 1719 по 1722 г. учился в Эдинбургском университете, изучал логику и богословие. По возвращении домой стал помогать отцу проводить службы и вскоре сам стал священником. За всю жизнь опубликовал только две работы – одну богословскую и одну математическую. Умер в 1761 году.

В 1763 году, уже после его смерти, была опубликована его работа, в которой была получена формула, впоследствии ставшая основой теоремы Байеса, без которой теперь не обходится ни один учебник теории вероятности и математической статистики. Причём при жизни Байес не придавал значения полученной им формуле и считал, что она не стоит публикации.

Байес давал своему результату богословскую трактовку. Говорил, что события предопределены богом, а если исход какого-либо события нам ещё не известен, то их «осуществимость» для нас зависит от наших представлений о других событиях, связанных с данным. Такие, несколько пространные рассуждения станут понятны, если перейти от богословской трактовки к математической.

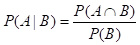

До Байеса была известна так называемая формула условной вероятности, которую он использовал в своих рассуждениях. Пусть А и В – некоторые события, как-то связанные между собой. Назовём вероятностью А при условии В (обозначается P(A|B)) вероятность того, что произойдет событие А если известно, что произошло событие В.

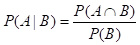

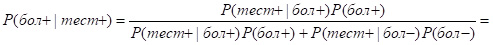

Формула условной вероятности имеет вид:

,

,

т.е. вероятность А при условии В равна вероятности того, что события А и В произойдут одновременно, поделенной на вероятность того, что произойдёт В.

Поясним суть формулы на простом примере. Пусть в корзине лежат 15 яблок. Каждое из яблок имеет красный, жёлтый или зелёный цвет, на некоторых яблоках есть пятна, на некоторых нет.

Распределение яблок по цветам и наличию пятен задано в таблице:

| Красн | Жёлт | Зел | |

|---|---|---|---|

| Без пятен | 2 | 2 | 1 |

| С пятнами | 4 | 1 | 5 |

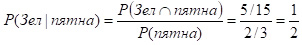

Пусть ваш товарищ наугад, не глядя, выбирает одно яблоко. Тогда вероятность того, что оно зелёное, равна (1+5)/15=2/5. Теперь представим себе, что товарищ сообщит нам, есть на выбранном яблоке пятна или нет.

Как теперь изменится вероятность (вернее, наши представления о вероятности) того, что было выбрано зелёное яблоко в зависимости от наших знаний о наличии пятен на яблоке. Из 15 яблок 10 с пятнами и 5 без, значит

P(пятна)=10/15=2/3, P(без пятен)=5/15=1/3, P(Зел)=6/15=2/5.

Итак, пусть мы узнали, что пятна есть. Тогда по формуле условной вероятности

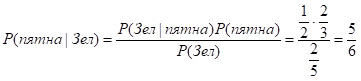

.

.

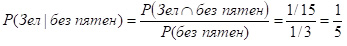

Если же пятен нет, то

.

.

Теперь посмотрим, как Байес преобразовал формулу полной условной вероятности.

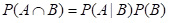

Итак,  , отсюда

, отсюда  .

.

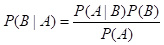

С другой стороны,  . Приравнивая два выражения для P(A∩B), имеем: P(A│B)P(B)= P(B│A)P(A), отсюда

. Приравнивая два выражения для P(A∩B), имеем: P(A│B)P(B)= P(B│A)P(A), отсюда  .

.

Это и есть формула Байеса. Используя её, рассчитаем, например, вероятность того, что выбранное яблоко – с пятнами, при условии, что оно зелёное.

Все данные для подстановки в формулу уже есть:

.

.

То, что Байес называл осуществимостью события, в настоящее время называется условной или апостериорной вероятностью. Продемонстрируем это понятие на примере.

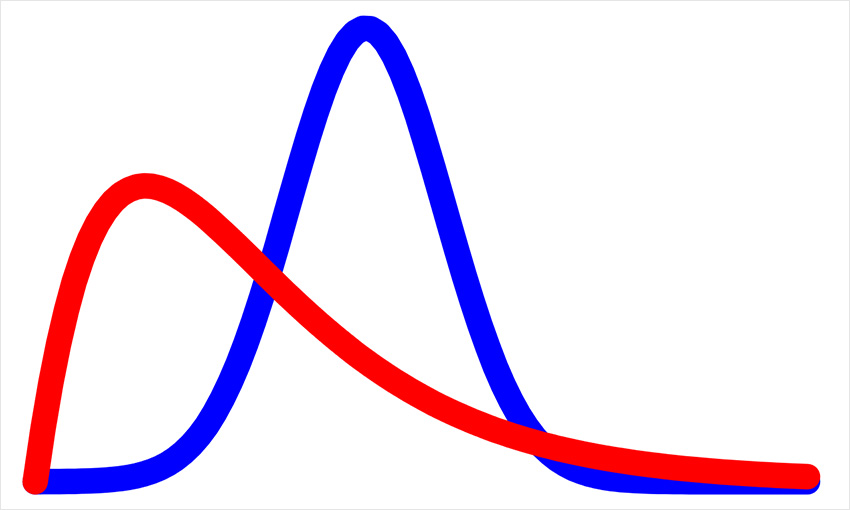

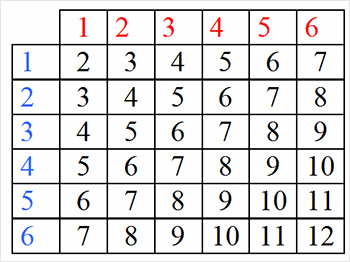

Пусть подбрасываются два игральных кубика, на каждом из которых нанесены цифры от 1 до 6. Пусть один из них окрашен в синий, а другой – в красный цвет.

Тогда может произойти один из 6·6=36 исходов, причём вероятности всех исходов равны между собой и составляют 1/36.

На рис. 1. показано, чему равна сумма очков на кубиках в зависимости от исходов.

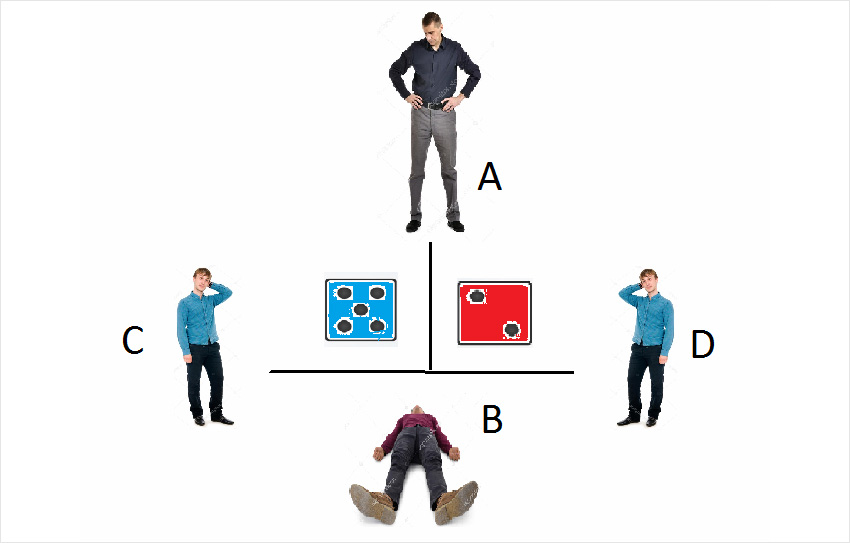

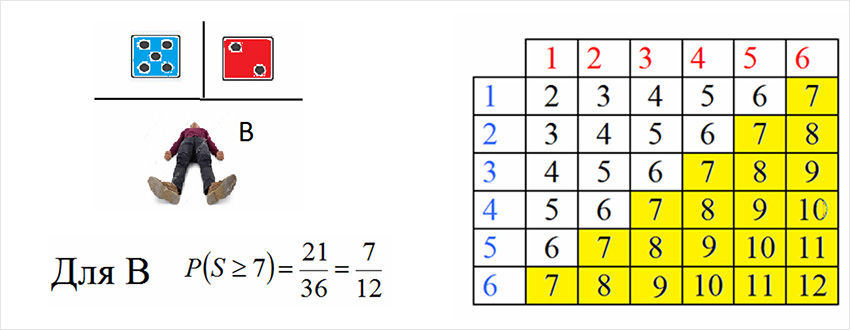

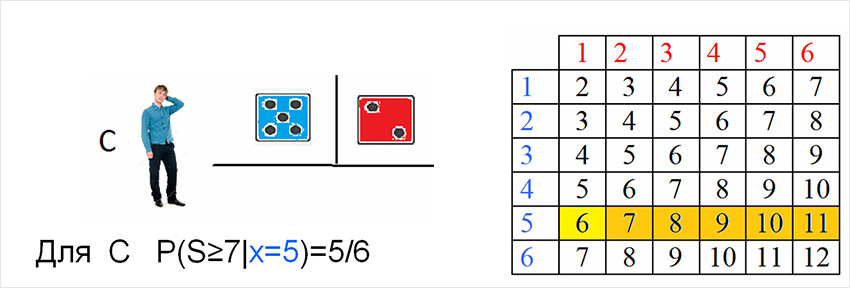

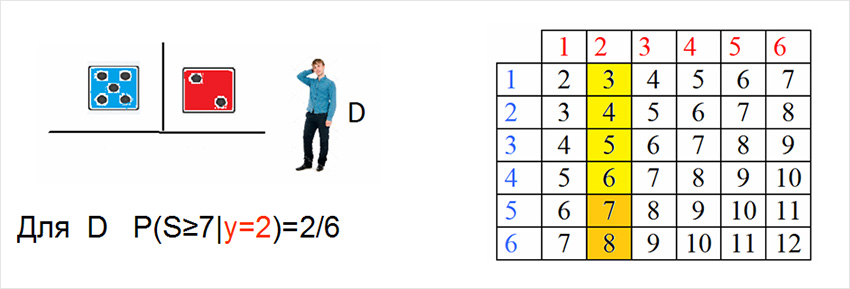

Предположим, что на синем кубике выпало 5, а на красном – 2, и бросок кубиков видят четыре наблюдателя – A, B, C, D. При этом А видит оба кубика, B не видит ничего, С видит только синий кубик, а В – только красный (рис. 2).

Рассмотрим условную вероятность того, что сумма на двух кубиках не меньше 7 с точки зрения каждого из наблюдателей.

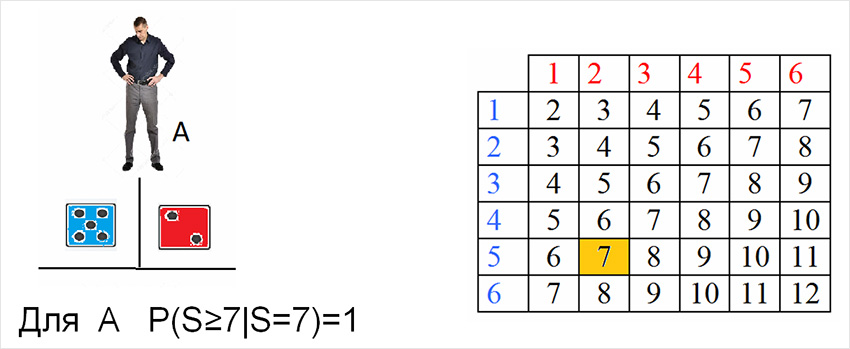

А видит оба кубика, поэтому для него множество возможных событий сведено к одному, и это событие является благоприятным, поэтому для него вероятность того, что выпало не менее 7 очков, равна 1 (рис. 3).

В не видит ничего, поэтому для него количество возможных событий равно 36, из которых 21– благоприятные, поэтому искомая условная вероятность равна 21/36 (рис. 4).

С видит, что на синем кубике выпала 5, но не видит красный кубик. Количество возможных событий для него равно 6 (по числу граней одного кубика), из них благоприятных – 5 (его устраивает любое число на красном кубике, кроме 1), поэтому искомая условная вероятность равна 5/6 (рис. 5).

D видит, что на красном кубике выпала 2, но не видит синий кубик. Количество возможных событий для него, как и для С, равно 6, из них благоприятных – 2 (его устраивает на красном кубике только 5 или 6), поэтому искомая условная вероятность равна 2/6 (рис. 6).

В настоящее время формула Байеса чаще используется в более общем виде, который базируется на так называемой формуле полной вероятности – другой важнейшей формуле из курса теории вероятностей.

Назовём группу событий B1, B2,…,Bn полной, если обязательно произойдёт одно из них и никогда не может произойти любые два события одновременно. В рассмотренном примере с яблоками полную группу событий образует множество исходов {Красное ябл.; Жёлтое ябл.; Зелёное ябл.}, или {Ябл. с пятнами, Ябл. без пятен}.

В примере с подбрасыванием пары кубиков можно привести множество групп событий, например {На красном кубике больше очков, чем на синем; На красном кубике меньше очков, чем на синем; Очки на кубиках равны}.

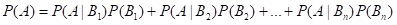

Итак, пусть B1, B2,…,Bn – полная группа событий, А – некоторое другое событие, тогда формула полной вероятности имеет вид:

,

,

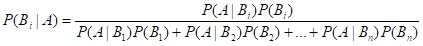

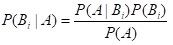

тогда формула Байеса приобретает следующий вид: для всех i от 1 до n выполняется равенство

,

,

или кратко

.

.

Покажем, как работают эти формулы на примере.

Задача о пересдаче зачёта. Пусть студент пересдаёт зачёт, и его будет принимать один из трёх преподавателей – А, В или С. А – добрый и примет зачёт с вероятностью 90%, В – умеренный – 60%, С – злой, и вероятность сдать ему зачёт – лишь 30%.

Пусть процедура пересдачи такая. Сначала декан назначает день пересдачи – это с равной вероятностью может быть один из пяти дней рабочей недели. Затем заведующий кафедрой с равной вероятностью назначает одного из преподавателей, у которых есть пары в назначенный деканом день.

Пусть выписка из расписания имеет вид:

| Пн | Вт | Ср | Чт | Пт |

| А, В, С | А | А, В | А, С | В, С |

Найдём вероятность того, что студент сдал зачёт. Для этого формулу полной вероятности нужно будет применить дважды.

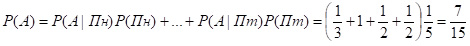

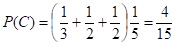

В начале найдём вероятности, с которыми будет назначен каждый из преподавателей:

.

.

Аналогично,

,

,  ,

,

тогда вероятность сдачи зачёта равна

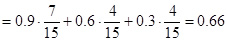

P(Зачёт)=P(Зачёт|А)P(А)+ P(Зачёт|В)P(В)+P(Зачёт|C)P(C)=

.

.

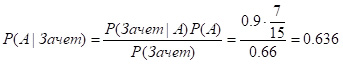

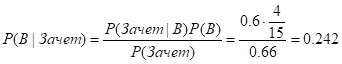

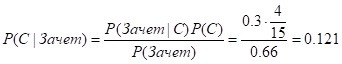

Поставим задачу по-другому. Пусть известно, что студент сдал зачёт, но неизвестно, кто из преподавателей его принял. Найти соответствующие вероятности поможет формула Байеса.

,

,

,

,

.

.

Читателю предлагается самостоятельно найти распределение вероятностей для преподавателей при условии, что студент не сдал зачёт.

В рассмотренном примере даже без вычислений можно предвидеть, что если студент получил зачёт, то его поставил скорее всего преподаватель А, поскольку он и на работе бывает чаще остальных, и зачёты принимает более лояльно.

Такого рода устные оценки без математических вычислений принято называть байесовскими рассуждениями. Многие люди руководствуются байесовским подходом, даже не осознавая этого.

Например, если сломался компьютер (или другой гаджет), то мы строим предположения, какой именно узел сломался, и что послужило причиной поломки. В ходе диагностики какие-либо причины видятся более вероятными, какие-то – менее вероятными, чем это было первоначально.

Интрига большинства детективов строится на угадывании того, кто является преступником. В ходе расследования и выяснения обстоятельств одни действующие лица становятся более подозрительными, другие – менее, затем при выяснении новых обстоятельств ситуация может измениться.

Рассмотрим такой пример байесовских рассуждений. Пусть был куплен станок и назначен работник, который его использует. Случилось так, что станок сломался в течение первой недели. Вы думаете, что причины поломки может быть две – либо станок имел технические дефекты, либо работник небрежный и нарушал правила эксплуатации.

При этом вы мысленно оцените, какая из причин более вероятная примерно таким образом: производитель имеет хорошую репутацию, его изделия, судя по отзывам других пользователей, надёжны и ломаются редко. Скорее всего, причина в небрежном использовании. Пусть станок был возвращён производителю и вместо него был получен другой станок, который сломался в течение следующей недели. Тогда ваше подозрение в том, что причиной поломки является небрежное использование, существенно возрастает, и на месте начальника вы, скорее всего, уволите такого работника, не дожидаясь третьей поломки.

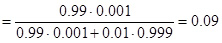

Рассмотрим пример, получивший название «капкан Байеса», который противоречит нашим интуитивным представлениям о распределениях вероятностей.

Пусть вы проходите медицинский осмотр, и вам назначают тест на редкую, но тяжёлую болезнь, которая встречается у 0.1% населения, и известно, что надёжность теста составляет 99%.

Если Ваш тест оказался позитивным – не отчаивайтесь! Вы полагаете, что больны на 99%, но это не так!

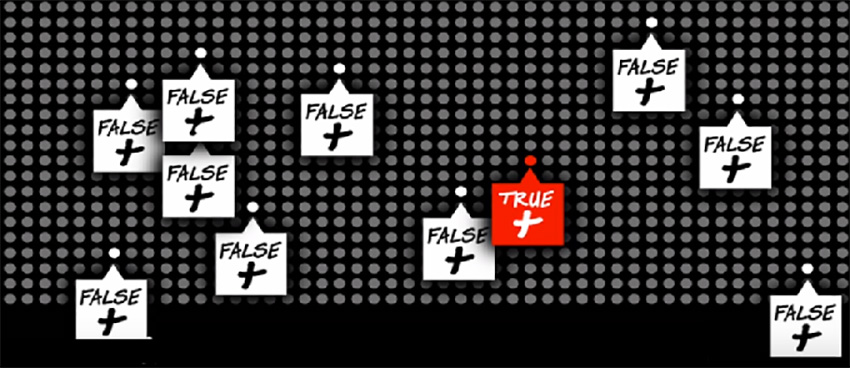

Применим формулу Байеса.

В данном случае есть две гипотезы - что вы больны (бол+) и что вы здоровы (бол-) и априорные вероятности и априорные вероятности гипотез вычисляются, исходя из распространённости болезни, поэтому P(болезнь+)=0.001, P(болезнь-)=0.999.

Условные вероятности болезни после прохождения теста определяются надёжностью теста и равны: P(болезнь+ | тест+)=0.99, P(болезнь- | тест-)=0.99.

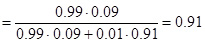

Тогда по формуле Байеса имеем:

Это значит, что вы больны на 9, а не на 99 процентов! Если вам не верится, то интерпретируем графически такой странный на первый взгляд вывод.

Пусть среди 1000 людей, сдавших тест, оказался один больной, тогда его тест действительно с вероятностью 99% будет позитивным (красная точка). Пусть ваш тест оказался позитивным, и вы считаете, что красная точка (одна из 1000) – это вы. Вовсе не обязательно. Дело в том, что среди прочих 999 здоровых позитивный тест окажется ошибочно у 999·0.01=10 человек (белые точки). Т.е. действительно больной человек – это 1 из 11 с позитивным тестом, что составляет 1/11=9%.

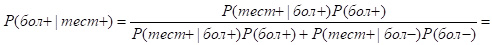

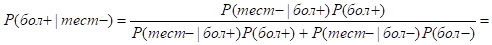

Пусть вы, получив положительный результат, решили сдать повторный тест с такой же достоверностью. Если и второй тест оказался позитивным – то вы в отчаянии, поскольку, по вашему мнению, шансов быть здоровым нет.

Чтобы вычислить условную вероятность болезни при условии второго положительного теста, подставим в уже использованную ранее найденную по формуле байеса вероятность болезни (9% или 0.09) в качестве априорной:

.

.

Так что шансы быть здоровым ещё есть.

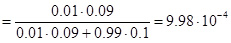

Предположим теперь, что после первого позитивного теста повторный оказался негативным, поэтому, поскольку тест достаточно надёжный, то вы полагаете, что ваши шансы быть больным примерно 50 на 50. Но это снова не так! Действительно,

,

,

а это значит, что вероятность болезни даже чуть уменьшилась по сравнению с изначальной априорной (т.е. до сдачи тестов) вероятностью.

Большинство людей, включая врачей, не понимают теорему Байеса и сопутствующие ей распределения вероятностей, что объясняет большой процент ложных диагнозов рака и других тяжёлых болезней.

Ещё одно важное применение теоремы Байеса – байесовская классификация. Рассмотрим этот метод на примере.

Пусть в супермаркете есть три вида фруктов – бананы, апельсины и лимоны. Каждый из фруктов имеет (или нет) три признака – продолговатый (или длинный), жёлтый, сладкий.

Например, может встретиться длинный, не жёлтый и не сладкий банан. Пусть было продано 100 фруктов, о которых была собрана такая статистика:

| Длинные | Сладкие | Жёлтые | Всего | |

|---|---|---|---|---|

| Бананы | 40 | 35 | 40 | 50 |

| Апельсины | 0 | 15 | 6 | 30 |

| Лимоны | 10 | 0 | 15 | 20 |

| 100 |

Заметим, что в данном случае суммы по строкам не равны значению в колонке «Всего», поскольку речь идёт о признаках, а не о классах (когда принадлежность к одной группе исключает принадлежность к другой). Например, банан может быть одновременно длинным, сладким и жёлтым.

Задача Байесовской классификации ставится в данном случае так: пусть был продан некоторый фрукт, какой именно неизвестно, зато известно, каким набором признаков он обладал (например, длинный, не сладкий и жёлтый). Нужно определить, какой это фрукт.

Если бы мы не знали набора признаков, то строили бы вероятностные предположения о фрукте на основе объёмов продаж (т.е. предположили бы, что на 50% это банан, на 30% – апельсин, а на 20% – лимон). Однако, зная признаки фрукта, можно построить более точные предположения (в частности, даже без вычислений ясно, что поскольку фрукт длинный, то это точно не апельсин).

По вероятностным предположениям об объёмах продаж определяем априорные вероятности: P(банан)=0.5, Р(апельсин)=0.3, P(лимон)=0.2.

Определим теперь условные вероятности признаков при условии, что известен вид фрукта.

Например, среди 50 бананов 40 длинных, 15 не сладких и 40 жёлтых, поэтому

P(длин|банан)=40/50=0.8, P(не сладк|банан)=15/50=0.3, P(жёлт|банан)=40/50=0.8.

Аналогично, P(длин|апельсин)=0/30=0, P(не сладк|апельсин)=15/30=0.5, P(желт|апельсин)=6/30=0.2, Р(длин|лимон)=10/20=0.5, Р(не сладк|лимон)=20/20=1, P(жёлт|лимон)=15/20=0.75.

Теперь предположим, что признаки являются независимыми, тогда вероятность того, что у данного фрукта встретится данный ряд признаков, равна произведению вероятностей. Так, например,

P(длин, не сладк, жёлт| банан)=P(длин|банан)·P(не сладк|банан)·P(жёлт|банан)= =0.8·0.3·0.8=0.192,

P(длин, не сладк, жёлт|апельсин)=0·0.5·0.2=0,

P(длин, не сладк, жёлт| лимон)=0.5·1·0.75=0.375.

Однако признаки не всегда являются независимыми, поэтому предположение о независимости признаков принято называть наивным, а сам метод – «Наивный Байес».

По формуле полной вероятности найдём вероятность того, что у случайно выбранного фрукта наблюдается ряд признаков (длинный, не сладкий, жёлтый):

P(признаки)=P(признаки|банан)P(банан)+ P(признаки|апельсин)P(апельсин)+ P(признаки|лимон)P(лимон)=0.192·0.5+0·0.3+0.375·0.2=0.171, тогда по формуле Байеса

P(банан|признаки)=P(банан)·P(признаки|банан)/P(признаки)=0.192·0.5/0.171≈0.56,

P(апельсин|признаки)=P(апельсин)·P(признаки|апельсин)/P(признаки)=0,

P(лимон|признаки)=P(лимон)·P(признаки| лимон)/P(признаки)=0.372·0.20.171≈0.44.

Т.е., исходя из имеющихся данных, можно заключить, что фрукт с данным набором признаков точно не апельсин, на 56% является бананом, а на 44% – лимоном.

Качественно это можно объяснить так: данный набор признаков исключает то, что это апельсин, и произведение условных вероятностей говорит в пользу того, что это скорее лимон, чем банан (0.375 против 0.192). Однако, поскольку в данном случае бананы встречаются в 2.5 раза чаще, чем лимоны (50% против 20%), то значения апостериорных вероятностей оказываются близкими между собой (56% и 44%).

Конечно, данный пример построен искусственно, он почти шуточный, однако при этом абсолютно серьёзно показывает, как происходит байесовская классификация.

Рассмотренный метод классификации стал составной частью таких современных и модных направлений прикладной математики, как интеллектуальный анализ данных, машинное обучение или обучение по прецедентам.

Приведённые термины являются в определённой степени синонимами, и их суть можно пояснить таким образом.

Пусть есть объекты, которые обладают некоторыми признаками (которые можно наблюдать, либо же установить, проведя анализ), и свойства (то, что нельзя увидеть непосредственно, но нужно установить или хотя бы попытаться предугадать). Пусть есть некоторый набор данных, для которых известны и признаки и свойства (называемый учебной выборкой). Нужно научиться на основе учебной выборки предсказывать свойства новых объектов, наблюдая их признаки.

Например, можно пытаться угадывать, из какой страны приехал человек по его внешнему виду и манере говорить. Учебной выборкой служит ваш жизненный опыт – мы ранее видели и слышали представителей разных стран и после этого пытаемся угадать гражданство человека, которого никогда не видели раньше.

Гораздо более серьёзная задача – медицинская диагностика. В этом случае в качестве признаков используются симптомы (насморк, кашель, покраснение кожи и т.д), а впоследствии – результаты анализов, а в качестве свойств – диагнозы.

В теореме Байеса на самом деле нет магии и волшебства, и её суть сводится к тому, что ваши убеждения достоверны настолько, насколько достоверны аргументы в их пользу.

Поэтому зачастую теорема Байеса (сама по себе являющаяся бесспорным утверждением) может быть использована в рекламе псевдонауки и суеверий, наряду со здравым смыслом. В этом случае теорема Байеса не развеивает псевдонаучные знания, а потакает им.

С.И. Доценко, кандидат физико-математических наук, доцент факультета информационных технологий КНУ имени Тараса Шевченко

По теме:

Основатель и издатель

Основатель и издатель Copyright © 2016–2021 Научно-популярный

Copyright © 2016–2021 Научно-популярный